Un algoritmo nuevo, sin precedentes, que podría ser empleado en el posicionamiento de robots exploradores, tipo Rovers, que la Administración Nacional de la Aeronáutica y del Espacio (NASA) envía en sus misiones a Marte, es propuesto por investigadores de la Escuela de Ingeniería Eléctrica (EIE) de la Universidad de Costa Rica (UCR).

La investigación es dirigida por el Dr. Geovanni Martínez Castillo, coordinador del Laboratorio de Investigación en Procesamiento Digital de Imágenes y Visión por Computador (IPCV-LAB), perteneciente a dicha Escuela.

La propuesta apunta a llegar muy alto e, inclusive, a hacer historia. Se denomina Algoritmo de odometría visual monocular basado en diferencias de intensidad, con el cual se lograría mejorar el conocimiento sobre cómo determinar la posición de un robot mediante el uso solamente de una cámara de video (cámara monocular), atada de forma rígida a su estructura y sin la ayuda de un Sistema de Posicionamiento Global (GPS), un Sistema de Medición Inercial o un Sistema de Escaneo Láser.

Según explicó Martínez, los Rovers que se posan en la superficie marciana solamente reciben instrucciones desde la Tierra una vez por día, por lo que debe ser capaz de realizar las funciones de transportarse para ejecutar sus tareas de recolección de información en forma autónoma y lo más eficiente posible.

“Un error de navegación podría causar la pérdida de un día entero de trabajo; por eso, para moverse en forma precisa deben de contar con un sistema que les permita estimar con exactitud su posición en todo momento”, detalló el investigador.

El algoritmo creado por Martínez le posibilita al robot determinar su posición en cualquier momento con mayor precisión, con el uso de una sola cámara, mientras que la actual tecnología emplea un arreglo de dos cámaras (cámara estereoscópica) para tal fin.

Una cámara estereoscópica agrupa a dos cámaras monoculares. Por ejemplo, el Curiosity utiliza una cámara estereoscópica para calcular su posicionamiento, antes y después del movimiento del robot, pero con solo una cámara monocular este nuevo algoritmo permite que el robot se ubique correctamente.

Este proyecto de la EIE se podría incluso fusionar con el algoritmo que usa la NASA para obtener resultados más confiables y precisos, o por si se presenta alguna falla, comentó Martínez.

¿Cómo se ubica un robot en Marte?

De acuerdo con el investigador, con las dos imágenes capturadas de forma simultánea por una cámara estereoscópica, es posible determinar la posición tridimensional de puntos característicos sobre una superficie planetaria, con base en una técnica denominada triangulación.

“El movimiento tridimensional del robot se estima tomando las correspondencias que se puedan establecer entre esas dos nubes de puntos; al integrarse el movimiento estimado a lo largo del tiempo es como se calcula la posición del robot en el espacio”, ahondó el experto.

“Eso es lo que hace el algoritmo de odometría visual estereoscópico de la NASA”, detalló. No obstante, el algoritmo planteado por él funciona diferente, pues utiliza una sola cámara.

Además, el movimiento tridimensional del robot no se estima al evaluar correspondencias entre puntos característicos, sino al evaluar las diferencias de intensidad entres dos imágenes de la superficie, las cuales fueron capturadas por la cámara antes y después del movimiento del robot, añadió.

El algoritmo desarrollado en el Laboratorio de la UCR tiene una precisión de menos de un 1 % de la distancia recorrida, lo que lo ubica dentro de los mejores algoritmos de odometría visual del mundo.

A modo de comparación, el algoritmo que usa el Curiosity en Marte tiene un error del 2 %; o sea, cuando el robot se mueve y el algoritmo es capaz de determinar la posición del robot y después de que ha avanzado 10 metros, el margen de error del cálculo de ubicación del robot será de 20 centímetros, mientras que el algoritmo propuesto desde la UCR sería de solo 10 centímetros.

“Es un trabajo que tiene ya seis años de estarse haciendo. Hemos podido validar este algoritmo fuera del laboratorio, en los alrededores del edificio de la EIE, pues es muy diferente probarlo en una computadora y hacer simulaciones, que ponerlo dentro del computador del robot y llevárselo para afuera, en donde hay cambios de clima, iluminación, viento fuerte, etc.”, expresó Martínez.

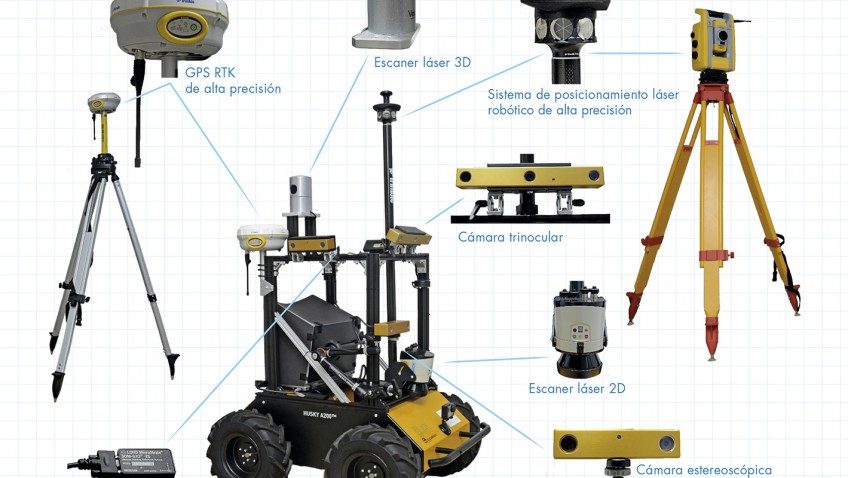

En dichas pruebas se calculó la trayectoria que seguirá el robot mediante el uso de varios instrumentos: una Estación total robótica que incluye un Sistema de posicionamiento láser robótico de alta precisión, un GPS RTK de alta precisión, un escáner láser 3D y otro 2D.

Según el especialista, “la Estación total robótica tiene un rayo láser que sigue el prisma ubicado en el Robot Visión (nombre del Rover que usan en el IPCV-LAB) e indica cada segundo la posición real. Después se pone a andar el robot y de la secuencia de imágenes obtenida por las cámaras, se calcula la posición y trayectoria con el algoritmo, se comparan los datos y los resultados concuerdan. La precisión del algoritmo es muy buena, pues ambas trayectorias son iguales”.

Otra variable que se debe tomar en cuenta es la reducción de los costos del equipo tecnológico que se necesita para trabajar en este tipo de proyectos, destacó el científico. Se requieren cerca de $35000 para la compra de un GPS RTK de alta precisión o $40000 de un Sistema de Escaneo Laser 3D y $6000 en un Sistema de Escaneo Láser 2D.

En cambio, si el robot utiliza solo una cámara con un costo de $100 y se le agrega el nuevo algoritmo, va a ser capaz de determinar en dónde se encuentra. “Una sola cámara pesa menos, requiere menos espacio y consume menos energía, aspectos que son muy importantes en la planificación de una misión espacial”, precisó el investigador.

En los próximos meses llegará al IPCV-LAB un nuevo robot, con el que se podrá probar el algoritmo en condiciones extremas, como son terrenos volcánicos, playas, márgenes de ríos, frío, lluvia, viento, humedad, calor y polvo, para dejarlo a la intemperie el tiempo que se pueda y saber cómo responde el algoritmo.

0 comments